Sie erstellen Texte, die im Hinblick auf Inhalt, Grammatik und Rechtschreibung einwandfrei sind.

Sie sind imstande, sich mit Menschen zu unterhalten und Kunden zu betreuen.

Sie entwickeln eigene Codes und lösen mathematische Rechenaufgaben.

Doch manchmal tun sie das komplette Gegenteil – und exakt an diesem Punkt wird es problematisch.

Die Rede ist von künstlichen Intelligenzen (KI), die die Form von Textgeneratoren, Chatbots oder anderen Programmen haben können. Der Hype um den Chatbot ChatGPT (auch GPT und GPT-3 genannt) um die Jahreswende 2022/2023 sowie die allgemein steigende Nutzung von Textgeneratoren hat uns dazu inspiriert, diesen Blogbeitrag zu verfassen.

Wir von Content-Erfolg sind eine Textagentur, die Web-Texte für Kunden mit verschiedensten Ansprüchen erstellt. Die Korrektheit der von uns verfassten Inhalte und ein der Zielgruppe angepasster Schreibstil sind zwei unserer Kernziele bei der Erstellung von Texten. Seit vielen Jahren verfolgen wir die Entwicklung von Textgeneratoren und KIs und erkennen die Fortschritte der Wissenschaft an.

Jedoch gibt es gewisse Herausforderungen, die selbst weit entwickelte Chatbots wie GPT in unseren Augen nie meistern werden. Dies macht sie für den Einsatz in der Texterstellung und in diversen weiteren Bereichen ungeeignet. An welchen Herausforderungen KIs scheitern, und welche Risiken für die Herausgeber von Texten dadurch entstehen – darum geht es in diesem Beitrag.

Wie funktioniert ChatGPT?

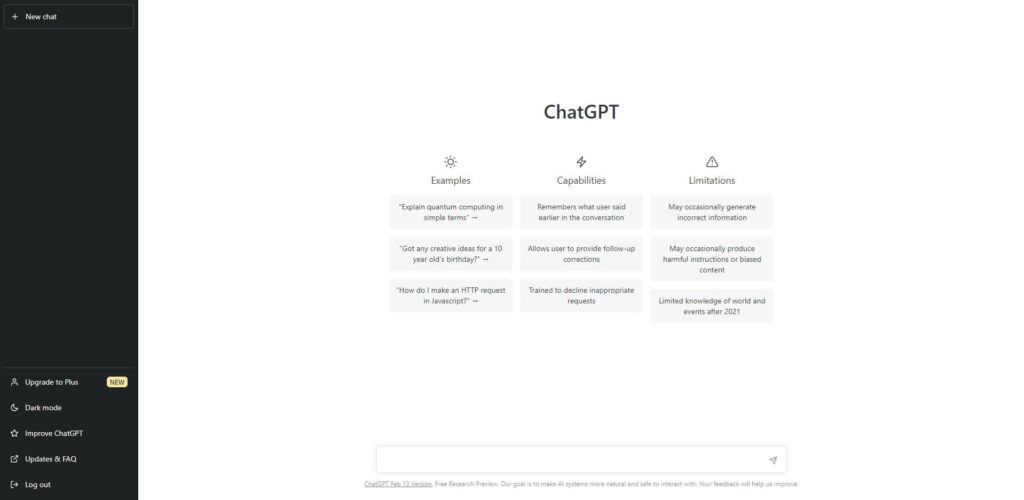

Um die Argumente in diesem Blogbeitrag zu verstehen, sind Grundkenntnisse über die Funktionsweise von Textgeneratoren hilfreich. Da ChatGPT derzeit (Stand: 2023) der wohl fortschrittlichste bekannte Textgenerator ist, möchten wir die Funktionsweise von Textgeneratoren am Beispiel von ChatGPT erläutern.

Als Basis für die Funktion von ChatGPT dient das Deep Learning. Im Deep Learning wird ein künstliches neuronales Netz geschaffen, das Maschinen dazu befähigt, eigenständig zu lernen und die gewonnenen Informationen zu hinterfragen. Hierzu füttern die Entwickler Maschinen wie ChatGPT mit Daten – beim Deep Learning sind das enorme Datenmengen!

- Aus den Daten, die der Maschine übermittelt werden, leiten die Entwickler logische Muster ab. Zudem klassifizieren sie die Daten. Die Muster und die Klassifizierung der Daten sind sozusagen eine Anleitung, mit deren Hilfe die Maschine selbstständig lernen kann.

- Anschließend verknüpfen die Entwickler neue Daten mit den bereits vermittelten Daten. So entsteht ein Netzwerk aus Verknüpfungen.

- Hat die Maschine einmal gelernt, wie diese Verknüpfungen hergeleitet werden, ist sie imstande, neue Datenbestände eigenständig in ihren Wissenskontext einzuordnen.

Die Aufzählung skizziert das Vorgehen beim Deep Learning nur rudimentär. Schon anhand dieser Erklärung zeigen sich allerdings die Parallelen zum menschlichen Lernverhalten. Denn der Mensch bettet Gelerntes ebenfalls in einen Kontext ein und eignet sich dadurch die Fähigkeit an, komplexe Probleme zu lösen.

Die Besonderheit von GPT-3 besteht darin, dass dieser Chatbot mit noch größeren Datensätzen trainiert wird, als es im Deep Learning ohnehin üblich ist. Gemäß Informationen von spektrum.de verwenden die Entwickler fürs Training von GPT-3 rund 570 GB an Text, was ungefähr einer Menge von einer Billion Wörtern entspricht.

So entsteht GPT-3. Es ist ein Chatbot, der schneller und besser lernt als alle anderen Chatbots, Textgeneratoren und künstlichen Intelligenzen zuvor. Die hohe Lernqualität führt zu dem, was viele Personen an GPT-3 begeistert: Der Chatbot kann wissenschaftliche Arbeiten, Texte, Gedichte und zahlreiche weitere Werke erstellen.

Zudem ist er imstande, Gespräche mit Menschen zu führen, mathematische Aufgaben zu lösen, technischen Code zu formulieren und diverse weitere Dinge durchzuführen. Allerdings ist das Defizit bei alldem, dass ChatGPT nicht weiß, was es tut. Mit diesem Defizit eröffnet sich ein Reigen an weiteren Problemen.

Das Kernproblem: Eine KI versteht nicht, sondern handelt gemäß Wahrscheinlichkeit

Für ein Beispiel wenden wir uns nun dem Kerngebiet unserer Textagentur zu: der Texterstellung. Ein menschlicher Autor bringt im besten Fall Vorwissen zu dem Thema mit, zu dem er einen Text verfasst. Sollte er dieses Vorwissen nicht haben, dann recherchiert er. Wenn er mit der Texterstellung beginnt, versteht er das Thema und die Zusammenhänge.

Eine KI wie ChatGPT hingegen versteht nicht. Sie errechnet auf Basis von Wahrscheinlichkeit, welches Wort bei der Texterstellung dem nächsten folgen sollte. Das gilt bei einer KI übrigens nicht nur für die Texterstellung, sondern auch für das Lösen mathematischer Aufgaben, die Antworten auf die Fragen von Menschen und weitere Aufgaben.

Eine KI rechnet immer auf Basis dessen, was sie im Deep Learning erlernt hat und selbst fortwährend lernt. Die unter Umständen negativen Folgen dieser Art der Entscheidungsfindung bei der Textverfassung und Gesprächsführung erklärt die Online-Zeitung DIE ZEIT im Artikel ChatGPT – Gut erfunden ist halb geglaubt:

- ChatGPT gibt als schnellstes Meeressäugetier den Wanderfalken an. Dieser ist allerdings kein Meeressäugetier.

- Somit ist ChatGPT außerstande, eine – gemessen am Schwierigkeitsgrad der sonstigen an ihn gestellten Fragen – recht einfache Frage korrekt zu beantworten.

- Eine Vermutung, weswegen der Wanderfalke als schnellstes Meeressäugetier angegeben wird, besteht darin, dass in englischen Artikeln im Zusammenhang mit dem Wanderfalken das Wort „dive“ des Öfteren auftaucht.

- Das englische Wort „dive“ kann sowohl als Sturzflug als auch als Tauchgang ins Deutsche übersetzt werden. Also assoziiert ChatGPT falsch und antwortet falsch.

Zugegebenermaßen handelt es sich bei Fehlern wie diesen um solche, die im Laufe der nächsten Jahre durch die Weiterentwicklung der KIs vermutlich behoben werden. Jedoch lässt sich dieses einfache Beispiel auf komplexere Probleme und Fragestellungen übertragen und verdeutlicht das Kernproblem: Eine KI wie ChatGPT kann sich keine Fähigkeit des logischen Denkens aneignen.

Während Menschen falsche Optionen von vornherein aus logischen Gründen ausschließen, folgt die KI auch diesen falschen Optionen und entwickelt darauf basierend Lösungswege, die womöglich überzeugend und korrekt klingen, jedoch kompletter Unsinn oder inkorrekt sind. Dies lässt sich am Beispiel von ChatGPT bei zahlreichen mathematischen Lösungswegen beobachten, bei denen schon der erste Schritt der Lösungsfindung falsch ist. Da bringt es nichts, wenn der Rest des Lösungsweges korrekt ist.

Die KI versteht also nicht, sondern errechnet die Wahrscheinlichkeit. Besonders fatal ist dies bei der Recherche. KIs, die beim Lernen nicht nur seriöse Informationsquellen anzapfen, wie es bei ChatGPT der Fall ist, könnten Falschinformationen verbreiten. Vor allem diesen Aspekt – den der Falschinformation, der sich am Beispiel von ChatGPT schon etliche Male gezeigt hat – sehen wir bei Content-Erfolg sehr kritisch. Wir stoßen bei unseren Recherchen mittlerweile immer häufiger auf Texte, die mit fehlerhaften oder mangelhaften Inhalten gespickt sind. Die allgemeine Qualität im Sektor der Texterstellung sinkt von Jahr zu Jahr.

In unseren Augen ist die Digitalisierung daher ein Zeitalter der zunehmenden Desinformation. Dieser Entwicklung verleihen Textgeneratoren, Chatbots und KIs wie GPT-3 noch mehr Auftrieb. Unserer Ansicht nach sind Textgeneratoren in ihrer aktuellen Qualität eine Gefährdung der Integrität von Websites und Medienhäusern, die Informationen verbreiten.

Wie das Beispiel des Wanderfalken gezeigt hat, können Textgeneratoren sogar bei den simpelsten Fragestellungen oder Aufgaben haarsträubende Fehler unterlaufen. Somit eignen sich Textgeneratoren entgegen weitläufigen Meinungen nicht mal für die Textverfassung im Niedrigpreissektor. Denn so gering die qualitativen Ansprüche im Niedrigpreissektor auch sein mögen, kann es keineswegs das Ziel sein, Websitebesuchern Texte zu präsentieren, in denen Wanderfalken als Meeressäugetiere und schlimmstenfalls sogar Bohrmaschinen als Kinderspielzeug kategorisiert werden.

Welche gravierenden Folgen die Verbreitung falscher Informationen haben kann, veranschaulichen wir anhand von drei Beispielen.

Drei Beispiele für gravierende Folgen durch den Einsatz von Textgeneratoren

Wir möchten an dieser Stelle gar nicht ausführlich darauf eingehen, weswegen eine KI für die Verfassung von Texten auf wissenschaftlichem oder hohem inhaltlichem Niveau ungeeignet ist.

Obwohl mit ChatGPT verfasste Studienarbeiten von Dozenten teilweise als gut bewertet wurden, ist die KI aufgrund des Risikos der Falschinformation und wegen der spezifischen Probleme beim Verfassen langer Texte (u. a. Verlust des roten Fadens, inhaltliche Wiederholungen, widersprüchliche Inhalte) trotzdem für Arbeiten auf hohem Niveau ungeeignet.

Vielmehr möchten wir in den folgenden drei Beispielen verdeutlichen, dass schon bei der Verfassung gewöhnlicher Website-Texte durch einen Bot wie ChatGPT Probleme auftreten können. Je nach Websitebetreiber und Branche handelt es sich um Probleme, die sogar hohe Strafen zur Folge haben können.

Aktualität von Inhalten

Bei der Recherche greift ein Textgenerator wie ChatGPT auf Datensätze aus dem Internet zurück. Unter den vielen Datensätzen mit aktuellen Informationen können sich auch solche befinden, die nicht mehr aktuell sind. Je länger der jeweilige Text ist, umso größer ist die Wahrscheinlichkeit, dass die KI, um den Text zu strecken, aktuelle mit inaktuellen Informationen vermischt.

Groß ist die Gefahr einer mangelnden Aktualität vor allem bei KI-generierten Texten über das Online-Marketing, in dem sich von Monat zu Monat oder spätestens von Jahr zu Jahr mehrere Dinge und Richtlinien ändern. Auch KI-generierte Texte, bei denen ein Bezug zur aktuellen Gesetzeslage (z. B. Förderungen bei erneuerbaren Energien, Mietrecht) geschaffen wird, könnten von veralteten Informationen übersät sein.

Inhalte, denen die Aktualität fehlt, werden meist von einem signifikanten Anteil der Leser erkannt. Folglich fällt die Absprungrate auf den einzelnen Webseiten hoch aus. Beides hat negative Auswirkungen auf die SEO. Außerdem wird der Google-Algorithmus stetig weiterentwickelt und ist immer besser imstande, nicht aktuelle Inhalte zu identifizieren und die davon betroffenen Webseiten im Ranking schlechter zu positionieren als Webseiten mit aktuellen Informationen.

Marktmanipulation durch Falschinfos

Zu den Finanzinstrumenten, die einem Verbot der Marktmanipulation unterliegen, gehören Wertpapiere. Sollte beispielsweise ein Online-Broker einen Blog betreiben und Kursprognosen veröffentlichen, darf er keine falschen Informationen streuen, die dazu führen könnten, dass das Kursniveau beeinflusst wird, so die Bundesanstalt für Finanzdienstleistungsaufsicht (BaFin) auf ihrer Website.

Nehmen wir an, dass der Online-Broker einen Textgenerator einsetzt und dieser bei der Erstellung einer Kursprognose täuschende Informationen streut. Der Broker begibt sich bei Veröffentlichung des Textes aufs Glatteis, da Marktmanipulation zu hohen Bußgeldern von bis zu 5 Millionen Euro (diese Höhe gilt für Einzelpersonen) führen kann.

Neben Online-Brokern sind auch Wertpapierhäuser und andere Distributoren von Informationen im Finanzsektor von dem Gesetz betroffen. Inwieweit der Kurs durch die Verbreitung von Falschinformationen tatsächlich beeinflusst wird und ob dafür der Distributor der Information verantwortlich gemacht werden kann, ist wiederum ein anderes Thema.

Abgesehen von dem Gesetz ist die Streuung von Falschinfos auch schädlich für die Leserschaft. Sollten Fehlinformationen gestreut werden, auf deren Basis Anleger und Trader ihre Handelsentscheidungen an der Börse treffen und Geld verlieren, so würde dies der Reputation der Website schaden.

Besonders problematisch ist unter diesem Blickpunkt, dass ChatGPT seine Kursprognosen so verfassen würde, als wäre er sich sicher, dass es so kommt. Unsicherheiten einräumen und dadurch den Lesern mehr Spielraum für eigene Entscheidungen lassen – das ist keine der Fähigkeiten, die ChatGPT in der Textverfassung hat. In Dialogen räumt ChatGPT auf Nachfrage zwar Unsicherheiten ein, doch in der Textverfassung tut der Textgenerator das nicht.

Verletzung von Health Claims

Neben dem Finanzsektor ist auch der Gesundheitssektor reguliert. Im Gesundheitssektor wurden z. B. Gesetze zum Umgang mit Health Claims (Gesundheitsversprechen) erlassen. Diese sehen unter anderem vor, dass Hersteller, Verkäufer und Vertreiber von Nahrungsergänzungsmitteln keine Gesundheitsversprechen formulieren dürfen, die auf das jeweilige Produkt nicht zutreffen.

Welche Health Claims zutreffend sind, hängt vom einzelnen Produkt ab. Die EU hat eine Liste von Health Claims definiert, deren Nutzung unter bestimmten Bedingungen zulässig ist. Zweifellos würde ein Textgenerator die Health Claims als relevantes Stichwort erwähnen. Doch bestünde im gleichen Zuge das Risiko, dass ein Generator wir ChatGPT trotzdem im Text großspurig und selbstsicher Gesundheitsversprechungen machen würde, die nicht zulässig sind.

Websitebetreiber, die mit Health Claims konforme Texte wünschen, sollten sich einzig und allein auf von Menschenhand erstellte Web-Texte verlassen. Passend hierzu haben wir einen Blogbeitrag veröffentlicht, in dem wir erläutern, wie mit Health Claims konforme Texte verfasst werden.

Was dem Textgenerator immer fehlen wird: Intuition und Praxiserfahrung

Selbst wenn ein Textgenerator inhaltlich korrekte Texte mit einem schlüssigen roten Faden erstellt, wird er gewisse menschliche Kompetenzen nicht an den Tag legen. Hierzu gehören Intuition und Praxiserfahrung. Beispielsweise wird eine KI niemals intuitiv die Dynamik im Text variieren, sondern stets ihr maschinelles und monotones Programm abspulen, was die Texte eintönig und unmenschlich klingen lässt.

Als große Schwäche von KIs gilt außerdem, dass sie keine Exkurse einlegen. KIs denken sich nicht, dass bei einem Thema ein Exkurs zu einem Randaspekt interessant wäre und Leser im Rahmen dieses Exkurses zu weiterführenden Themen weitergeleitet werden könnten. Als Folge dessen gehen interessante Themenpotenziale und außerdem für die SEO wichtige Verlinkungspotenziale verloren, die sich bei der Einbindung von Exkursen in Texte ergeben würden.

Der Mangel an Praxiserfahrung, den Textgeneratoren wie ChatGPT haben, ist bei Textarten wie Schritt-für-Schritt-Anleitungen, Tutorials und vielen Ratgebertexten fatal. Weil sich die Maschine nicht in die Abläufe hineinversetzen kann, die für Menschen bei der Umsetzung einer Anleitung besonders anspruchsvoll sind und mehr Erklärung bedürfen, wird sie bei der Textverfassung die Schwerpunkte des Öfteren falsch setzen. Es entstehen auf diese Weise Ratgebertexte, die wenig hilfreich oder sogar irritierend sind.

Fazit

Wenn es den Entwicklern von Textgeneratoren irgendwann gelingt, das menschliche Gehirn mitsamt allem, was dazugehört, zu imitieren, dann werden Textgeneratoren wie Menschen schreiben können und für die Texterstellung eine Option sein. Solange Textgeneratoren den Sprung auf „Gehirnniveau“ nicht vollziehen, sind sie in unseren Augen jedoch für die Texterstellung gänzlich ungeeignet.

Die haarsträubenden Fehler bei einfachen Fragestellungen und die Unfähigkeit, einen Text mit halbwegs passablem rotem Faden zu erstellen, disqualifiziert Textgeneratoren sogar für Recherchezwecke. Mit aktuellem Stand sollten ChatGPT und Co. wegen der hohen Gefahr an Falschinformationen nicht mal in eine Suchmaschine eingebunden werden, wie es Microsoft im Februar 2023 bei seiner Suchmaschine Bing durchgeführt hat.

Websitebetreiber, Unternehmer und Medienhäuser sind unserer Meinung nach besser damit beraten, für die Texterstellung auf menschliches Personal zu vertrauen. Die Texte einer professionellen Textagentur sind so hochqualitativ und konversionsstark, dass sich die Kosten durch den größeren Erfolg, der der hohen Textqualität zu verdanken ist, in der Regel refinanzieren.

Quellenangaben:

https://www.bigdata-insider.de/was-ist-deep-learning-a-603129/

https://www.zeit.de/digital/internet/2022-12/chatgpt-kuenstliche-intelligenz-openai-chatbot

Ich kann die Meinung nur vertreten!

Obwohl ich ChatGPT und die Fähigkeiten der KI begeisternd finde, wird es nie Menschen ersetzen können und das vor allem nicht im Hinblick auf qualitatives Texten. Sprache hat immer etwas Menschliches an sich, wozu etwas Künstliches nie in der Lage sein wird.